Забекапить ЖЖ: обзор опробованных опций

Проблема архивации блога всё насущнее.

Время идет, прежние рецепты действуют не все и не всегда.

Логичным было начать с наиболее часто упоминаемого ljArchive.

Поговаривали, что разработчики его больше не поддерживают;

страничка в сети httрljarchive.sourceforge.net не рабочая,

но у меня в запасе нашелся нераспакованный дистрибутив,

еще с тех времен, когда все было на ходу.

Установила, запустила - живое, работает. Требует пароль.

Прекрасно закачал файлы журнала, шустро, без сбоев и заминок перевел архив

в формат HTML - который можно смотреть в обычном браузере.

На этом можно было бы обзор и закачивать, если б не одно но -

не захватывает картинки. Ни файлами, ни в кодах, в виде ссылок.

На месте изображений - пусто.

Для фотоблога это не вариант.

Не менее известен заточенный под LJ Семаджик.

Привычный, давно под рукой, иногда в нем посты готовлю.

Оказалось, что умеет делать синхронизацию: т.е. не только отправлять записи,

но и обратно закачивать целым архивом -

Ссылки -> Синхронизация

Запускается без особых хитростей, никаких особенных настроек не требует.

Увы. Регулярно застревает, сообщая об ошибках сервера.

Процесс удается возобновлять до определенного предела, потом глохнет намертво.

У меня в неоднократных пробах доходил до мая-15 и на этом всё;

жевал долго, почти весь день в фоновом режиме.

Жжешный движок всё время меняют, Semagic отстает,

хотя и держит работоспособность дольше прочих.

Вроде бы не мало, всего-то нескольких последних месяцев не докачались,

но есть еще одна загвоздка - архив можно или просматривать в самом Sem-ке,

или расковыривать XML вручную и переформатировать во что-то более внятное.

Предусмотренная конвертация в хтмл так и не заработала.

Почему не родной ЖуЖевый httрwww.livejournal.com/export.bml "Экспортировать весь журнал"?

- На каждый месяц экспорт надо запускать отдельно. Одного этого хватит, чтоб забыть о таком сервисе.

Очень проста в управлении утилита Alexf LJ Downloader ( Jan 7 2005)

Красиво всё скачала, со ссылками-картинками и авторским форматированием (оформлением записи),

в облегченном стиле - без боковых колонок, фонов и баннеров.

Недостаток - совершенно невразуметильный интерфейс. Хотя и предельно лаконичный.

GetLJ (вводим имя журнала) -> Index (какое-то время определяются линки) -> Get

чтобы это ни значило. Методом тыка выявлено, что так работает.

Довольно быстро, меньше часа на все про все.

За результатами нужно идти в папку, куда они сохранились

(по умолчанию в ту же, куда разархивирована сама программа).

Не цепляет подзамки. У меня их минимум, так что не существенно.

Комменты есть, в развернутом виде, но только первая страница.

Каждая запись отдельным html-файлом, плюс еще в папочках страницы ссылок по месяцам.

Это уже реально архив.

Хоть на компьютере у себя хранить, хоть закинуть на какой-нибудь Диск или Облако.

Для разнообразия можете попробовать похожие:

The LiveJournal Backup Toolkit

thejackol com/2004/05/29/the-livejournal-backup-toolkit/

или

ljcolligo

code.google com/p/ljcolligo/

В принципе задача выполнена.

Но хотелось большего.

Скопировать в локал все иллюстрации, напр.

С привязкой к посту, в том порядке, в котором они расположены.

За время существования блога случилось сменить несколько фото-хранилищ,

некоторые уже не служат как сервисы, лишь каким-то чудом отдают картинки.

Полный бек-ап не помешал бы.

По сборникам бекаперов для ЖЖ ходят упоминания "консольных программ",

всем, наверное, хороших и действенных, за исключением того, что упоминающие сами их не пробовали

(ибо тот, кто разбирается, для неспецов вместе с декстопными такие упоминать не будет).

Видели в кино - сидит хакер и программные коды молотит на черном экране? Вот это оно.

Если знаете, где у вас "черное окно" и как восстановить систему,

если вдруг пойдет не так, как задумано - то LJSM и иже самое то.

ljbook нахваливают, одно время усиленно продвигали.

Скачивает ЖЖ и преобразует в РDF.

Со всеми иллюстрациями, текстами, заголовками,

книжным шрифтом, с разбиением на страницы.

Даже подарочное издание предлагают выпустить - цветная печать на глянцевой бумаге.

Солидная контора, сразу видно.

Сувенирный вариант мне без надобности, но автоматизированная закачка привлекает,

а конвертировать полученный РDF в какой угодно формат вроде бы не проблема.

Пятьдесят записей тестового блога загрузил в пару минут.

С картинками. Без комментов.

С припиской "Не забудьте внести донейт!" на титульной странице "книги".

Фото отресайзенные, сжатые-пережатые, в жутком качестве.

Спасибо, не надо.

А не замахнуться ли на суровые веб-инструменты, типа Телепорта?

Есть несколько вариаций т.н. офф-лайн браузеров.

(теряющих популярность в силу развития каналов связи и доступности онлайна)

Самым продвинутым из обще-пользовательских считается OfflineExplorerPro

Множество настроек. Есть режим "Скачать блог".

Триальный период в пятнадцать дней - на один бек-ап более чем.

Но пропускает только 2000 файлов - вместе с картинками не уложиться.

Почти такой же по функциональности (в рамках заданной цели) WebCopierPro

Интерфейс проще, и - без ограничения на закачки в пробный период (30 дней триал)

Если пользоваться Мастером нового проекта, то вообще ни в чем разбираться не надо.

Но есть шанс, что программа попытается закачать весь интернет

Вручную надежней. Открыть Новый проект и шаг за шагом переходить по настройкам в левой колонке.

Всё достаточно очевидно, только на вкладке УРЛ-фильтров требуется тщательная настройка.

С возможной последующей корректировкой:

"Пауза" ->"Свойства проекта" - допускается изменять характеристики в процессе.

В консоли отображаются очередные закачки. Если грузится что-то не то - можно прямо там

остановить процесс, вызвав меню щелчком мыши.

Кст. - качать лучше не с ЖЖ, который ныне увешан рекламными блоками

как новогодняя елка, а с Дрима. Установить для блога самый простой стиль без наворотов.

См тут. http://fotovivo.livejournal.com/202180.html

HTTRack

Бесплатный. Примерно те же возможности, что у предыдущих.

(Стоит с одним разобраться - остальные не слишком отличаются.)

Мощные штуки. Хотя управляться с ними - как ракету настраивать.

Непродуктивно для единичной задачи. Но, охота пуще неволи =)

В общих чертах - если имеется сайт и у него главная страница с оглавлением,

то в настройках закачки остается указать исходный пункт, запретить переход по внешним ссылкам

и загрузчик уровень за уровнем выкачает весь ресурс.

А вот с блогом - засада. С любой страницы - переходы на главную соц.сети.

Из комментов - в журналы френдов. Ограничить уровень до 1 - скачается только отправная страница,

поставить глубину скачивания в три уровня (напр: общая страница тегов, страницы каждой метки, сами записи) -

через переход на Главную и в Профиль программа все-равно исхитрится выкачать половину ЖЖ.

Ограничить сервер по имени пользователя - не загрузятся картинки, за что боролись.

Приходится изощрятся с фильтрами. У ЖЖ море привходящих адресов.

Даже если отключить сайдбар и не пускать качалку в Профиль, остаются - страница комментариев,

"написать комментарий", "треды" - ветки для каждого коммента с отдельными адресами и прочая.

Вместо тысячи страниц записей загрузятся семь тыщ страниц с одним и тем же содержанием.

Примерный список фильтров, если вдруг кому :

Страницы вашего ЖЖ - Редактировать метки / Редактировать запись / Предыдущий пост

(урлы в жж скопировать) и добавить шаблоны исключений

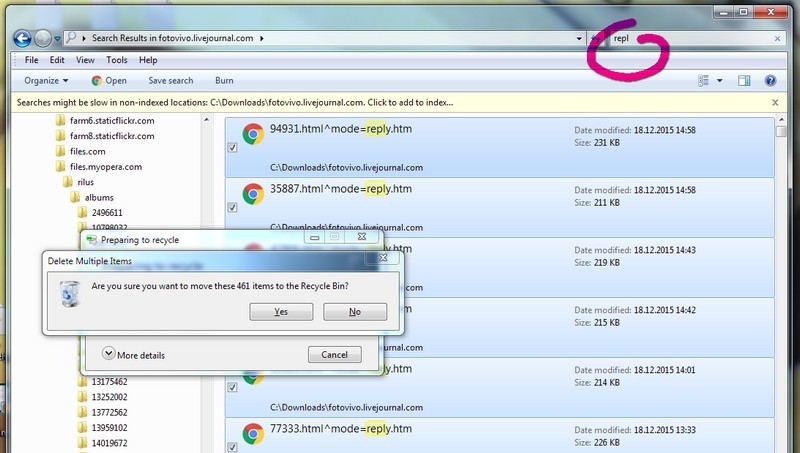

_^thread=

_html^mode=reply.htm/

_html^mode=reply.htm/

_/?skip

_/tag/

_html?page=

_html?replyto=

_html?thread=

_html?mode=reply

_html#comments

_manage/subscriptions/entry.bml?journal=fotovivo&itemid=

_editjournal.bml?journal=fotovivo&itemid=

Что-то удается отсечь, что-то корректировать на ходу... Развлечение на любителя.

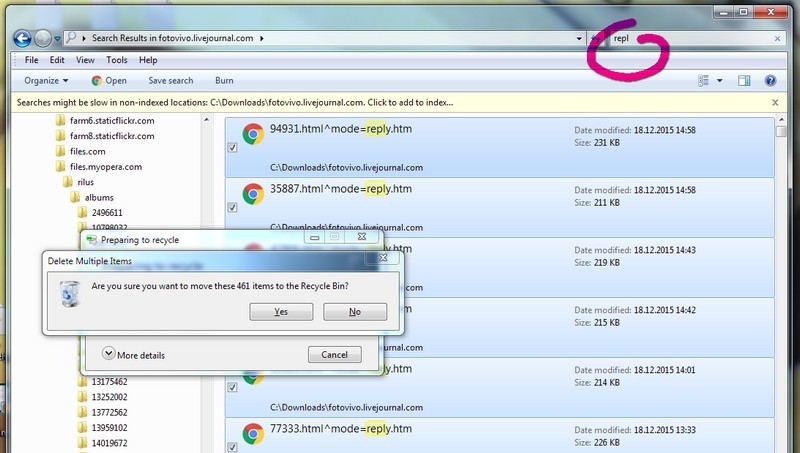

(повторяющиеся файлы системы "оставить комментарий" упорно проскакивают через фильтры.

Их не трудно выделить поиском и удалить все разом)

ScrapBook

браузерное расширение

в Хроме ничего не наскребло,

в ФайрФоксе запускается и вполне себе работает

скачать-установить -> открыть в разделе "боковые панели" -> ScrapBook

Открываем страницу, которую собираемся скачивать,

захватываем значок в адресной строке и перетягиваем на боковую панель Скрапбука.

В панели появляется новый каталог для этой страницы, щелчок мышкой, в меню выбираем опции сохранения.

Посмотреть что получилось - в том же меню: "Открыть".

странно было бы ожидать от примочки к браузеру больших возможностей,

чем у полновесной декстопной программы. Идеология та же, что у вышерассмотренных качалок.

И настройки не менее затейливы.

У Скрапа есть другие интересные опции, но об этом в следующий раз

Во всех прогах куча всякой графической мелочи копируется

Если вообще загружать графику.

Картинки комментаторов со всех мыслимых и немыслимых сетевых ресурсов.

Отсеивать нужное / ненужное фильтрами не проще, чем убрать мусор из каталога по окончанию загрузки.

И каждый смайлик в отдельную папочку укладывается - а чаще в несколько вложенных,

подобно тому, как он на исходном сервере хранился.

"Скачать сайт целиком" - универсальные инструменты понимают буквально и тянут все подряд.

Виджеты, скрипты для раскрытия катов, переходов по наведению, значки-стрелочки-черточки:

Что со всем этим делать?

Хранить и открыть-полюбоваться в первозданном виде можно.

А привести в удобопредставимый вид, так чтоб куда-нибудь еще запостить - тьма-тьмущая ручной работы.

Не проще ли тупо по одному посты копировать, прямо со страниц? (Cохранить как... -> HTML)

Есть лучший путь. В каждый пост заходить не потребуется.

Продолжение следует.

АПД - https://fotovivo.livejournal.com/809948.html

Лучшая из опций по соотношению трудоемкость / простота

Время идет, прежние рецепты действуют не все и не всегда.

Логичным было начать с наиболее часто упоминаемого ljArchive.

Поговаривали, что разработчики его больше не поддерживают;

страничка в сети httрljarchive.sourceforge.net не рабочая,

но у меня в запасе нашелся нераспакованный дистрибутив,

еще с тех времен, когда все было на ходу.

Установила, запустила - живое, работает. Требует пароль.

Прекрасно закачал файлы журнала, шустро, без сбоев и заминок перевел архив

в формат HTML - который можно смотреть в обычном браузере.

На этом можно было бы обзор и закачивать, если б не одно но -

не захватывает картинки. Ни файлами, ни в кодах, в виде ссылок.

На месте изображений - пусто.

Для фотоблога это не вариант.

Не менее известен заточенный под LJ Семаджик.

Привычный, давно под рукой, иногда в нем посты готовлю.

Оказалось, что умеет делать синхронизацию: т.е. не только отправлять записи,

но и обратно закачивать целым архивом -

Ссылки -> Синхронизация

Запускается без особых хитростей, никаких особенных настроек не требует.

Увы. Регулярно застревает, сообщая об ошибках сервера.

Процесс удается возобновлять до определенного предела, потом глохнет намертво.

У меня в неоднократных пробах доходил до мая-15 и на этом всё;

жевал долго, почти весь день в фоновом режиме.

Жжешный движок всё время меняют, Semagic отстает,

хотя и держит работоспособность дольше прочих.

Вроде бы не мало, всего-то нескольких последних месяцев не докачались,

но есть еще одна загвоздка - архив можно или просматривать в самом Sem-ке,

или расковыривать XML вручную и переформатировать во что-то более внятное.

Предусмотренная конвертация в хтмл так и не заработала.

Почему не родной ЖуЖевый httрwww.livejournal.com/export.bml "Экспортировать весь журнал"?

- На каждый месяц экспорт надо запускать отдельно. Одного этого хватит, чтоб забыть о таком сервисе.

Очень проста в управлении утилита Alexf LJ Downloader ( Jan 7 2005)

Красиво всё скачала, со ссылками-картинками и авторским форматированием (оформлением записи),

в облегченном стиле - без боковых колонок, фонов и баннеров.

Недостаток - совершенно невразуметильный интерфейс. Хотя и предельно лаконичный.

GetLJ (вводим имя журнала) -> Index (какое-то время определяются линки) -> Get

чтобы это ни значило. Методом тыка выявлено, что так работает.

Довольно быстро, меньше часа на все про все.

За результатами нужно идти в папку, куда они сохранились

(по умолчанию в ту же, куда разархивирована сама программа).

Не цепляет подзамки. У меня их минимум, так что не существенно.

Комменты есть, в развернутом виде, но только первая страница.

Каждая запись отдельным html-файлом, плюс еще в папочках страницы ссылок по месяцам.

Это уже реально архив.

Хоть на компьютере у себя хранить, хоть закинуть на какой-нибудь Диск или Облако.

Для разнообразия можете попробовать похожие:

The LiveJournal Backup Toolkit

thejackol com/2004/05/29/the-livejournal-backup-toolkit/

или

ljcolligo

code.google com/p/ljcolligo/

В принципе задача выполнена.

Но хотелось большего.

Скопировать в локал все иллюстрации, напр.

С привязкой к посту, в том порядке, в котором они расположены.

За время существования блога случилось сменить несколько фото-хранилищ,

некоторые уже не служат как сервисы, лишь каким-то чудом отдают картинки.

Полный бек-ап не помешал бы.

По сборникам бекаперов для ЖЖ ходят упоминания "консольных программ",

всем, наверное, хороших и действенных, за исключением того, что упоминающие сами их не пробовали

(ибо тот, кто разбирается, для неспецов вместе с декстопными такие упоминать не будет).

Видели в кино - сидит хакер и программные коды молотит на черном экране? Вот это оно.

Если знаете, где у вас "черное окно" и как восстановить систему,

если вдруг пойдет не так, как задумано - то LJSM и иже самое то.

ljbook нахваливают, одно время усиленно продвигали.

Скачивает ЖЖ и преобразует в РDF.

Со всеми иллюстрациями, текстами, заголовками,

книжным шрифтом, с разбиением на страницы.

Даже подарочное издание предлагают выпустить - цветная печать на глянцевой бумаге.

Солидная контора, сразу видно.

Сувенирный вариант мне без надобности, но автоматизированная закачка привлекает,

а конвертировать полученный РDF в какой угодно формат вроде бы не проблема.

Пятьдесят записей тестового блога загрузил в пару минут.

С картинками. Без комментов.

С припиской "Не забудьте внести донейт!" на титульной странице "книги".

Фото отресайзенные, сжатые-пережатые, в жутком качестве.

Спасибо, не надо.

А не замахнуться ли на суровые веб-инструменты, типа Телепорта?

Есть несколько вариаций т.н. офф-лайн браузеров.

(теряющих популярность в силу развития каналов связи и доступности онлайна)

Самым продвинутым из обще-пользовательских считается OfflineExplorerPro

Множество настроек. Есть режим "Скачать блог".

Триальный период в пятнадцать дней - на один бек-ап более чем.

Но пропускает только 2000 файлов - вместе с картинками не уложиться.

Почти такой же по функциональности (в рамках заданной цели) WebCopierPro

Интерфейс проще, и - без ограничения на закачки в пробный период (30 дней триал)

Если пользоваться Мастером нового проекта, то вообще ни в чем разбираться не надо.

Но есть шанс, что программа попытается закачать весь интернет

Вручную надежней. Открыть Новый проект и шаг за шагом переходить по настройкам в левой колонке.

Всё достаточно очевидно, только на вкладке УРЛ-фильтров требуется тщательная настройка.

С возможной последующей корректировкой:

"Пауза" ->"Свойства проекта" - допускается изменять характеристики в процессе.

В консоли отображаются очередные закачки. Если грузится что-то не то - можно прямо там

остановить процесс, вызвав меню щелчком мыши.

Кст. - качать лучше не с ЖЖ, который ныне увешан рекламными блоками

как новогодняя елка, а с Дрима. Установить для блога самый простой стиль без наворотов.

См тут. http://fotovivo.livejournal.com/202180.html

HTTRack

Бесплатный. Примерно те же возможности, что у предыдущих.

(Стоит с одним разобраться - остальные не слишком отличаются.)

Мощные штуки. Хотя управляться с ними - как ракету настраивать.

Непродуктивно для единичной задачи. Но, охота пуще неволи =)

В общих чертах - если имеется сайт и у него главная страница с оглавлением,

то в настройках закачки остается указать исходный пункт, запретить переход по внешним ссылкам

и загрузчик уровень за уровнем выкачает весь ресурс.

А вот с блогом - засада. С любой страницы - переходы на главную соц.сети.

Из комментов - в журналы френдов. Ограничить уровень до 1 - скачается только отправная страница,

поставить глубину скачивания в три уровня (напр: общая страница тегов, страницы каждой метки, сами записи) -

через переход на Главную и в Профиль программа все-равно исхитрится выкачать половину ЖЖ.

Ограничить сервер по имени пользователя - не загрузятся картинки, за что боролись.

Приходится изощрятся с фильтрами. У ЖЖ море привходящих адресов.

Даже если отключить сайдбар и не пускать качалку в Профиль, остаются - страница комментариев,

"написать комментарий", "треды" - ветки для каждого коммента с отдельными адресами и прочая.

Вместо тысячи страниц записей загрузятся семь тыщ страниц с одним и тем же содержанием.

Примерный список фильтров, если вдруг кому :

Страницы вашего ЖЖ - Редактировать метки / Редактировать запись / Предыдущий пост

(урлы в жж скопировать) и добавить шаблоны исключений

_^thread=

_html^mode=reply.htm/

_html^mode=reply.htm/

_/?skip

_/tag/

_html?page=

_html?replyto=

_html?thread=

_html?mode=reply

_html#comments

_manage/subscriptions/entry.bml?journal=fotovivo&itemid=

_editjournal.bml?journal=fotovivo&itemid=

Что-то удается отсечь, что-то корректировать на ходу... Развлечение на любителя.

(повторяющиеся файлы системы "оставить комментарий" упорно проскакивают через фильтры.

Их не трудно выделить поиском и удалить все разом)

ScrapBook

браузерное расширение

в Хроме ничего не наскребло,

в ФайрФоксе запускается и вполне себе работает

скачать-установить -> открыть в разделе "боковые панели" -> ScrapBook

Открываем страницу, которую собираемся скачивать,

захватываем значок в адресной строке и перетягиваем на боковую панель Скрапбука.

В панели появляется новый каталог для этой страницы, щелчок мышкой, в меню выбираем опции сохранения.

Посмотреть что получилось - в том же меню: "Открыть".

странно было бы ожидать от примочки к браузеру больших возможностей,

чем у полновесной декстопной программы. Идеология та же, что у вышерассмотренных качалок.

И настройки не менее затейливы.

У Скрапа есть другие интересные опции, но об этом в следующий раз

Во всех прогах куча всякой графической мелочи копируется

Если вообще загружать графику.

Картинки комментаторов со всех мыслимых и немыслимых сетевых ресурсов.

Отсеивать нужное / ненужное фильтрами не проще, чем убрать мусор из каталога по окончанию загрузки.

И каждый смайлик в отдельную папочку укладывается - а чаще в несколько вложенных,

подобно тому, как он на исходном сервере хранился.

"Скачать сайт целиком" - универсальные инструменты понимают буквально и тянут все подряд.

Виджеты, скрипты для раскрытия катов, переходов по наведению, значки-стрелочки-черточки:

Что со всем этим делать?

Хранить и открыть-полюбоваться в первозданном виде можно.

А привести в удобопредставимый вид, так чтоб куда-нибудь еще запостить - тьма-тьмущая ручной работы.

Не проще ли тупо по одному посты копировать, прямо со страниц? (Cохранить как... -> HTML)

Есть лучший путь. В каждый пост заходить не потребуется.

Продолжение следует.

АПД - https://fotovivo.livejournal.com/809948.html

Лучшая из опций по соотношению трудоемкость / простота