Восемь экспонент искусственного интеллекта (3)

<< Предыдущая часть: 2. Вычислительный бюджет на обучение ИИ <<

3. Эффективность микроэлектроники

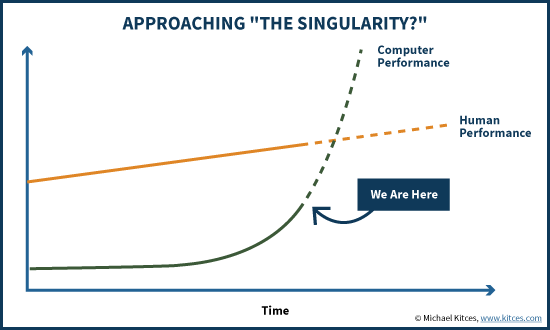

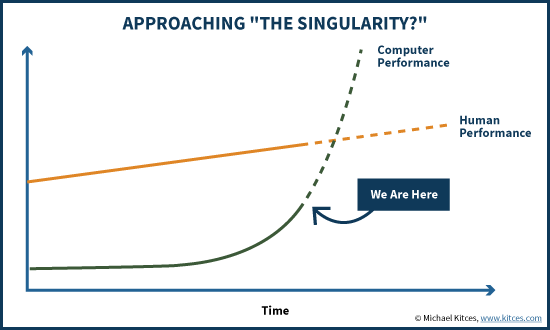

Идеи технологической сингулярности и непрерывного, поступательного роста способностей ИИ куда-то к невообразимым, сияющим высотам красивы, философски нетривиальны и подразумевают кардинальные изменения во всех аспектах жизни нашего общества. Но на чем теоретики - Вернор Виндж, Ханс Моравек, Рэй Курцвейл - основывали свои грандиозные прогнозы? Какие убедительные доказательства они приводят в пользу своих весьма радикальных взглядов на будущее?

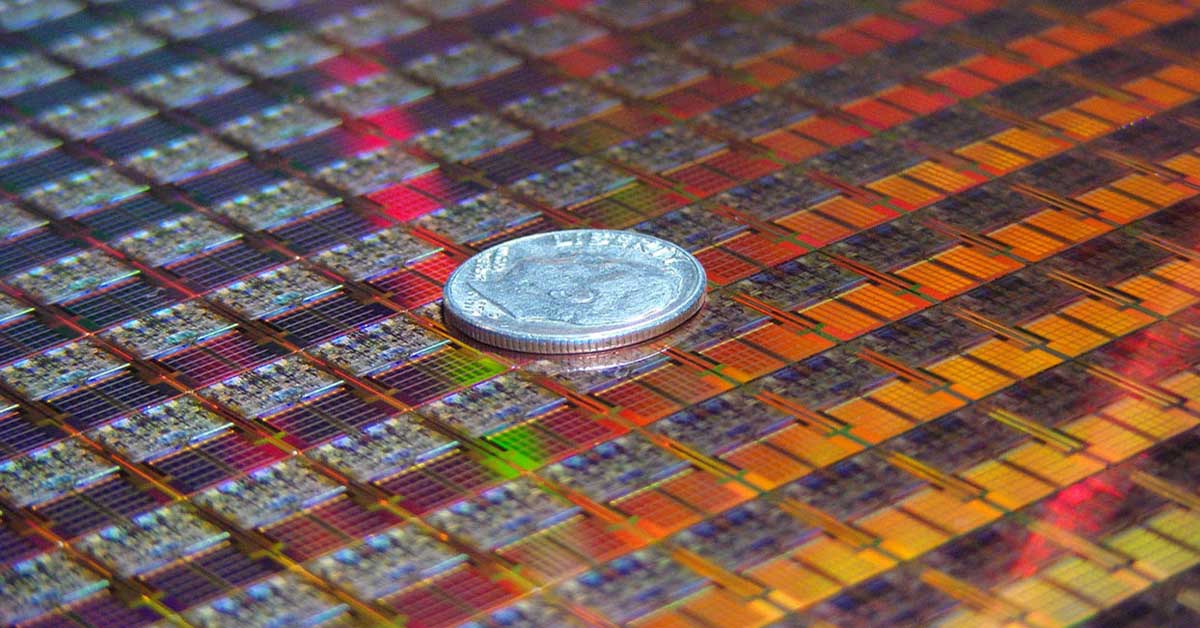

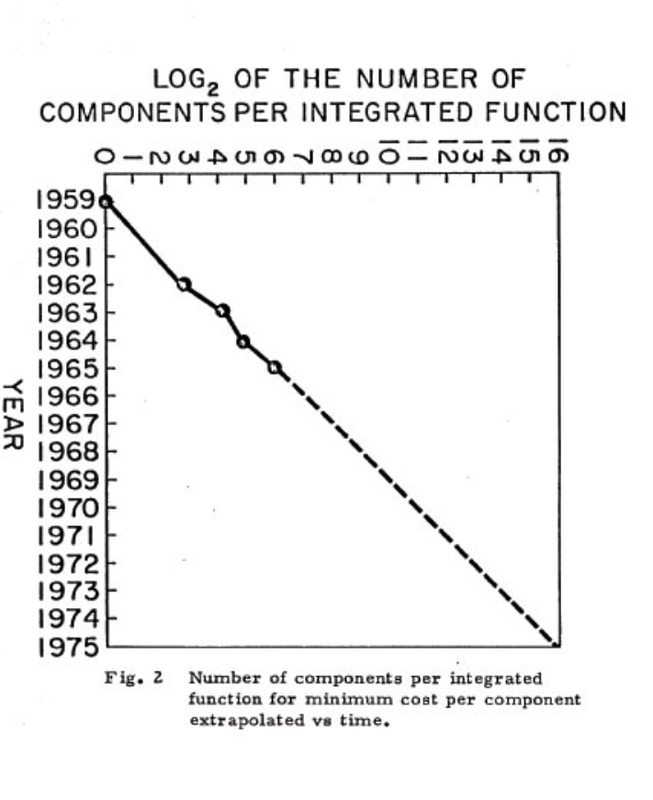

Если убрать все несущественные разногласия, мы приходим лишь к одному необходимому и достаточному условию, своего рода фундаменту, на котором покоится уверенность визионеров в экспоненциальном прогрессе. Это условие было открыто почти 60 лет назад. В 1965 году вышла статья, которая провозгласила новую эпоху в развитии полупроводниковой индустрии. Эпоху, которая продолжается и поныне, хотя автора статьи уже нет на этом свете. Автором был молодой инженер, научный директор компании «Fairchild Semiconductor» Гордон Мур.

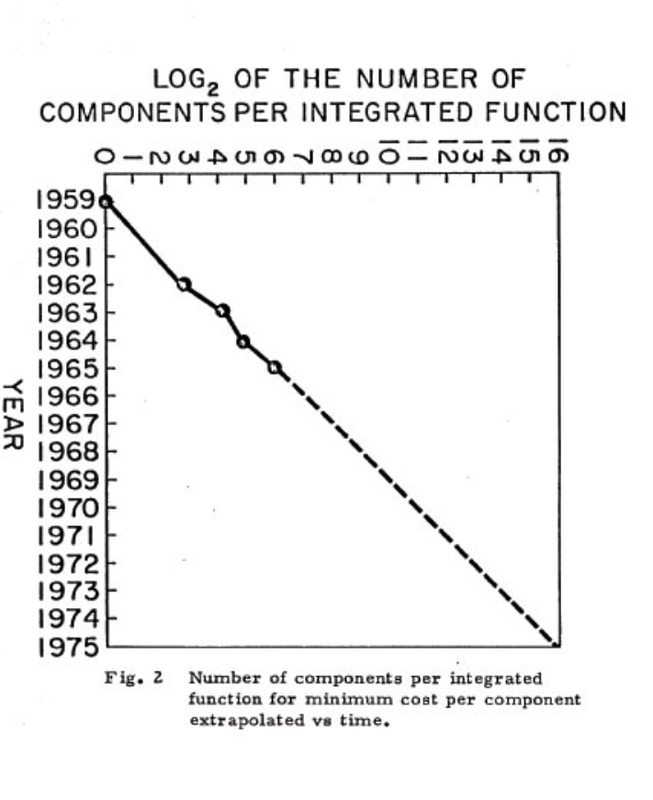

И один из важнейших законов этой эпохи был сформулирован Муром следующим образом: чем больше транзисторов мы сможем интегрировать в одном чипе - тем дешевле будет их себестоимость. При этом удваивать число транзисторов в чипе с 1959 (когда был изготовлен первый планарный кремниевый транзистор) по 1965 удавалось каждые 12 месяцев. Если продлить этот тренд в будущее, писал Мур, к 1975 году мы сможем делать микросхемы с 65 тыс. транзисторов - умопомрачительное число с учетом того, что в момент написания статьи самый сложный чип имел всего 50 транзисторов.

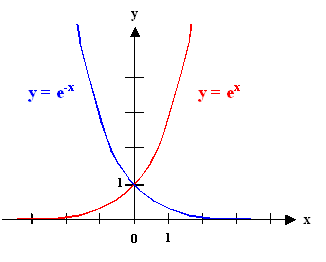

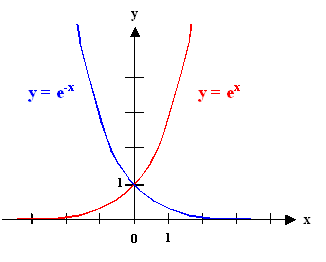

Так в нашем рассказе появляется особая разновидность экспоненты: функция экспоненциального убывания. Математически разница в том, что показатель является отрицательным:

Но нас, конечно, больше интересует практическая разница. Её можно описать так. Обычная экспонента подразумевает экстенсивный рост - больше параметров, больше вычислений, больше обучающих данных и так далее. Экспоненциальное убывание описывает интенсивный рост, рост эффективности: мы получаем больше пользы от того же самого количества ресурсов.

Итак, насколько хорошо Гордон Мур спрогнозировал в будущее этот тренд эффективности? Оригинальный прогноз, до 1975 года, неплохо выдержал проверку временем. Под конец этого срока Мур стал чуточку скептичнее: полупроводниковая индустрия уже срывала последние «низковисящие плоды», и после 1980 г. Мур прогнозировал замедление прогресса, с удвоением каждые два года.

На выручку закону Мура пришли его коллеги, Роберт Деннард и Дэвид Хаус. Первый вывел зависимость, что с уменьшением размера транзисторов уменьшается их энергопотребление, что позволяет повысить тактовую частоту вычислителей. Второй обобщил наблюдения Деннарда и Мура, придя к выводу, что производительность компьютеров будет удваиваться каждые 18 месяцев.

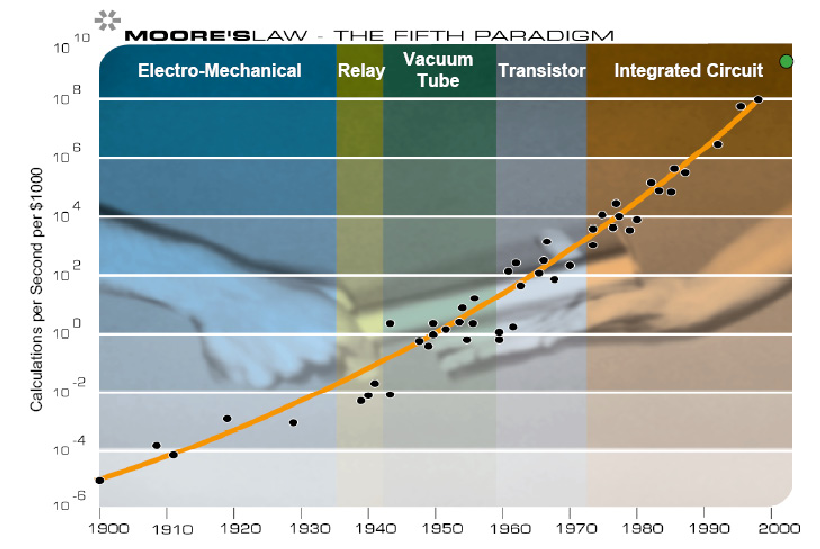

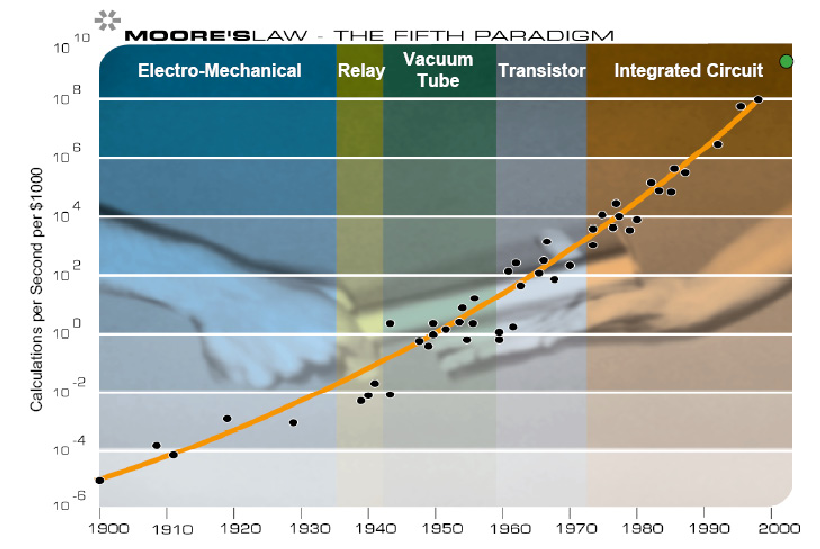

В таком виде закон Мура продержался несколько десятилетий. И лёг в основу смелых прогнозов о неизбежности скорого прихода общего искусственного интеллекта. Так, в книге Рэя Курцвейла «The Age of Spiritual Machines» от 1999 года мы увидим вот такой любопытный график:

А любопытен он тем, что, во-первых, Курцвейл расширяет микроэлектронный закон Мура на предыдущие вычислительные технологии, вроде ламп, реле и электромеханических устройств. Во-вторых, футуролог использует метрику «вычисления в секунду на $1000». Это очень хорошая метрика - другие формулировки, вроде плотности размещения транзисторов на микросхеме или номинальной производительности в FLOP/s, не так хорошо увязываются с другими экспонентами ИИ.

В-третьих, вертикальная ось на этом графике имеет логарифмический масштаб. Соответственно, экспоненциальная линия на самом деле является дважды экспоненциальной: темп удешевления вычислений не постоянен и продолжает постепенно ускоряться. «Скорость компьютеров (в расчете на единицу стоимости) удваивалась каждые три года с 1910 по 1950, каждые два года с 1950 по 1966, и сейчас удваивается каждый год», - пишет Курцвейл.

Логика диктует, что скоро производительность компьютеров будет удваиваться каждые полгода, затем каждый месяц, затем каждую неделю… Ну как тут не уверовать в сингулярность? Но нет, у всякой красивой концепции есть свои скептики, и закон Мура - не исключение.

Поскольку закон Мура - одна из самых широко известных экспонент, о нем было построено немало прогнозов и предположений. В основном они вращались вокруг того, что же и когда именно его остановит. Надо сказать, что технологический прогресс с таким темпом - это очень необычный феномен, имеющий мало аналогов в других отраслях промышленности. Закон Мура в этом плане - исключение из общих правил. И эксперты логично предполагали, что скоро это исключение исчерпает свои предпосылки.

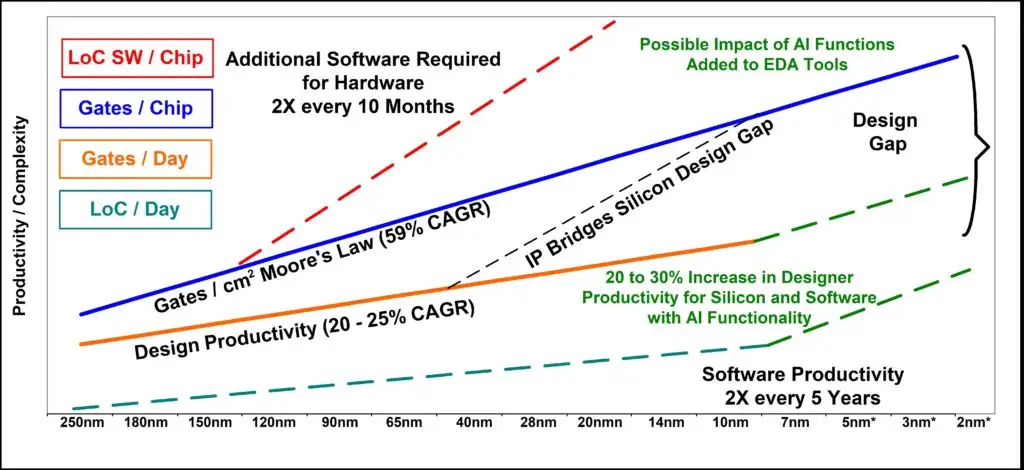

Одна из самых ранних попыток «похоронить» закон Мура была в 1984, когда полупроводниковой индустрии следовало переходить на 1-микронный техпроцесс. Число транзисторов в чипе должно было вырасти до 300 тысяч. И эксперты недоумевали: как инженеры смогут проектировать такие сложные устройства? Индустрия только-только начала переходить от проектирования на ватмане за кульманом к специализированному программному обеспечению…

Эксперты оказались не правы: прогресс в микроэлектронике подтолкнул прогресс в цифровых инструментах проектирования, и эта положительная обратная связь продолжает работать и сегодня.

Впрочем, эта ошибка не смутила скептиков, и вскоре последовали новые прогнозы о конце закона Мура. Особенно усилились мрачные предсказания, начиная с нового тысячелетия. Даже сам Курцвейл писал на этот счет: «После 60 лет добросовестной службы, закон Мура умрёт славной смертью не позднее 2019 года. К этому времени элементы транзистора будут всего несколько атомов шириной, и стратегия всё более тонкой фотолитографии исчерпает себя».

На этот раз прогнозы оказались ближе к реальности. Первым пало масштабирование Деннарда, в 2004-05 годах. C уменьшением размера транзистора ниже определенного порога физика сделала невозможным дальнейшее увеличение тактовой частоты. Чуть позже, в 2008, микроэлектронная ассоциация ITRS нарисовала для индустрии более «льготный» долгосрочный план по уменьшению размеров транзисторов, чем следовало из закона Мура. И почти сразу же начала от него отставать.

2019-ый уже прошел. Транзисторов шириной в отдельные атомы мы до сих пор так и не дождались. В 2023 ушел в мир иной сам Гордон Мур. Но жив ли еще закон его имени?

Если раньше эксперты спорили по поводу того, какое именно препятствие в будущем положит конец закону Мура, то сейчас ожесточенные дебаты разгорелись по поводу того, наступил этот конец или еще нет. Мнения разделились. Так, преемник Мура на посту главы «Интел» Пат Гелсинджер уверяет, что прогресс по-прежнему идёт с высоким темпом. Еще один влиятельный представитель полупроводниковой индустрии, глава «Нвидиа» Дженсен Хуанг, начиная с 2017 твердит, что закон Мура мёртв. Но всякий раз прибавляя, что только видеокарты смогут обеспечивать прогресс в эффективности вычислений, и обещая 1000-кратный рост производительности с 2017 по 2025.

Поскольку именно «Нвидиа» производит сейчас львиную долю вычислителей, использующихся для обучения ИИ-моделей, разумно будет оценить состояние закона Мура по характеристикам ее устройств. Посмотрим на эту табличку, где собраны данные по ускорителям «Нвидиа» для датацентров, начиная с 2011 года:

...И мы можем видеть, почему в середине 2010-ых у Дженсена Хуанга появились поводы для недовольства. Лучше все у полупроводниковой индустрии получалось менять таблички с названиями техпроцессов. За 11 представленных лет темп смены этих табличек даже чуть-чуть обогнал обещанное Муром удвоение каждые 24 месяца. Последняя табличка, «4 нм», даже подразумевает пресловутую «ширину в несколько атомов», пускай и в 2022-ом, а не в 2019-ом.

Но под табличками - см. колонку с плотностью транзисторов - нас ждет разочарование. Начиная с 2013, транзисторы упорно отказывались выполнять задекларированные обязательства и уменьшались в размерах далеко не так сильно, как подразумевало название техпроцесса. Особенно характерный пример мы видим с 12-нм техпроцессом: производитель, компания TSMC, табличку сменил, а транзисторы уменьшить «забыл».

Динамика цен тоже не внушает оптимизма. За ускоритель C2070 с чипом площадью 529 мм2 потребитель когда-то выкладывал 4 тыс. долларов. Спустя 11 лет H100 с чипом площадью 814 мм2 обойдется покупателю в 9 раз дороже. Ну ладно, пока дадим ценам шанс и спишем хотя бы часть удорожания на монопольное положение «Нвидиа» и мощный всплеск спроса на ее ускорители.

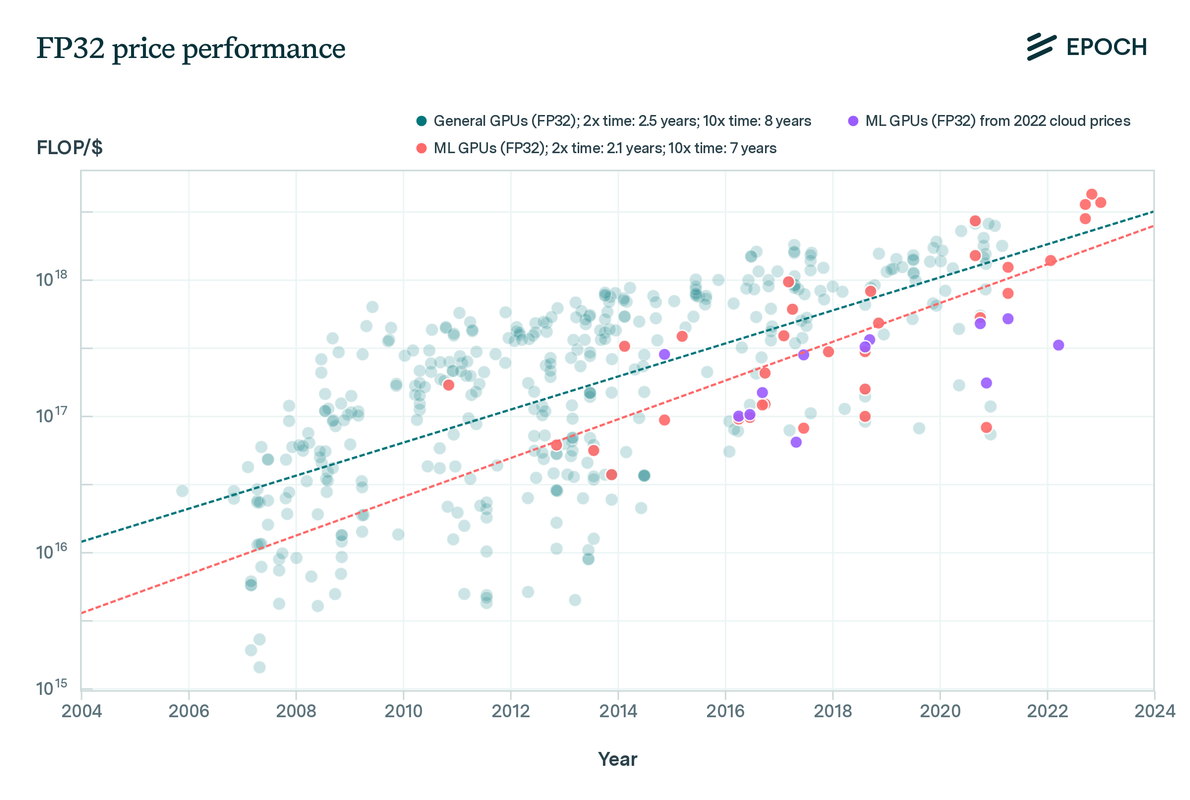

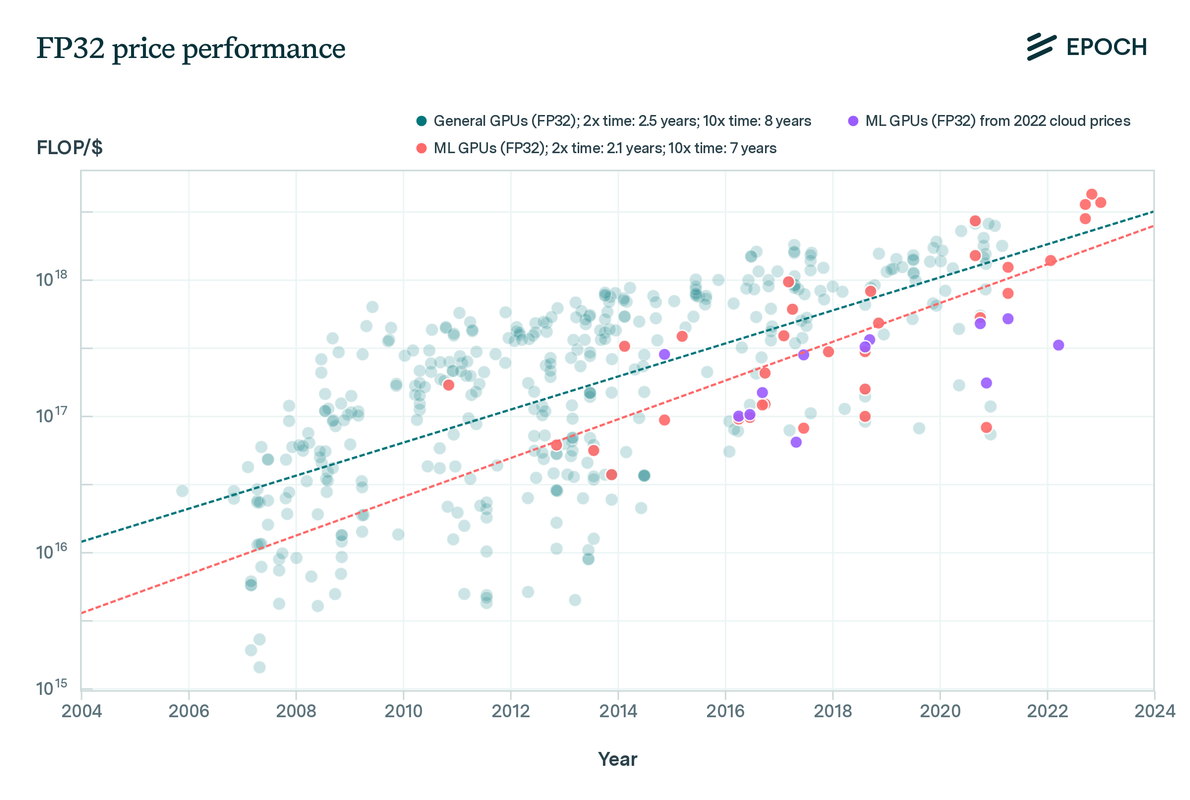

Благо мы можем оценить курцвейловский показатель «вычисления в секунду на $1000» более точно. Вновь благодаря исследователям из ”EpochAI”. Вот так выглядят агрегированные ими данные:

На этом графике мы видим тренд стоимости операций с плавающей точкой 32-битной точности. Авторы исследования рассчитывают тренд для GPU и получают удешевление в 2 раза каждые 2,1 года. Ура? Закон Мура жив?

Не так быстро: красные точки в правом верхнем углу графика - это свежие потребительские видеокарты, на которых скорее надо гонять «Киберпанк 2077», а не приближать этот самый киберпанк скучным обучением машинных моделей. Фиолетовые точки ML-ускорителей проигрывают им целый порядок. Да и тренд роста там далеко не такой бодрый.

В чем же дело? Во-первых, в том, что для машинных моделей 32-битная точность является избыточной. Последние несколько лет стандартом для индустрии является 16-битная точность. А в нынешнем году начались и попытки перехода на 8-битную. Работа машинных моделей в целочисленном 4-битном формате сейчас тоже является очень «горячей» темой. Производители ускорителей оптимизируют свои ML-устройства в первую очередь под эти форматы.

Ссылаясь на недостаточное количество данных, ”EpochAI” не рассчитывает трендов для этих типов вычислений. Но, на глазок, период 2-кратного удешевления здесь примерно такой же, как и для 32-битных операций с плавающей точкой.

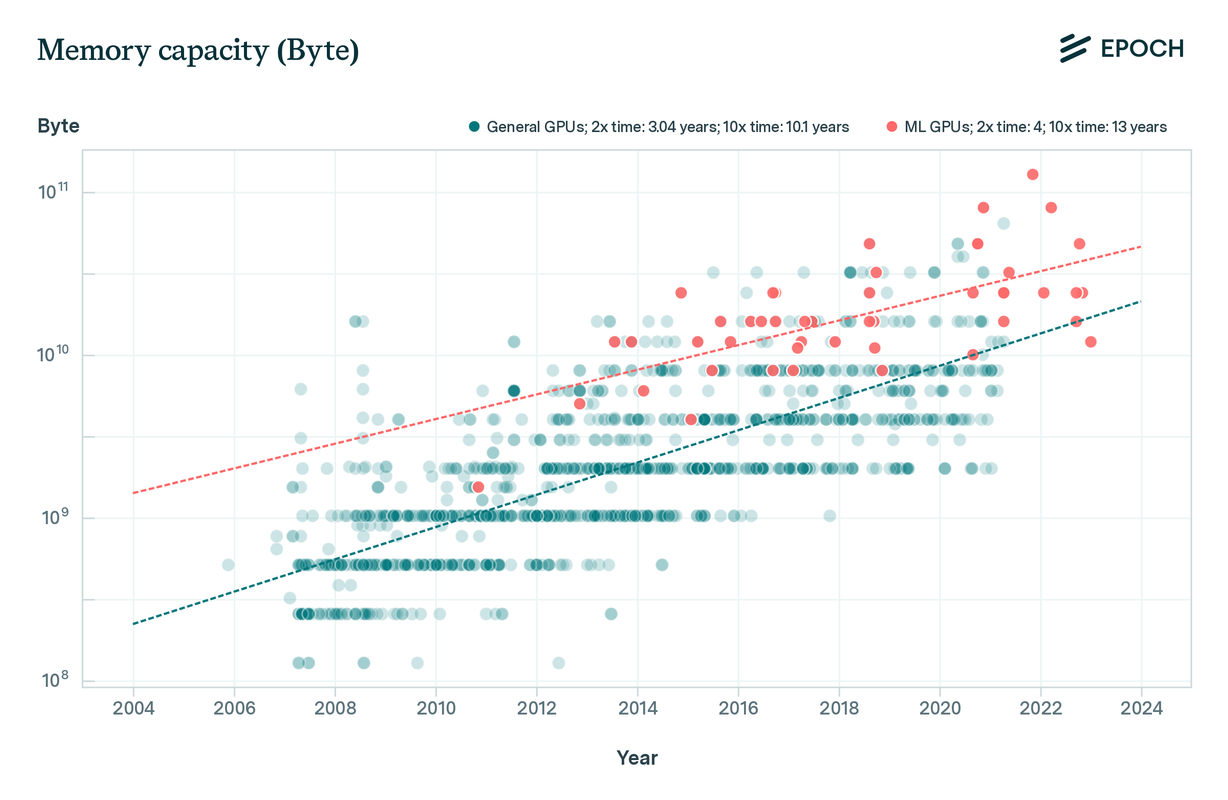

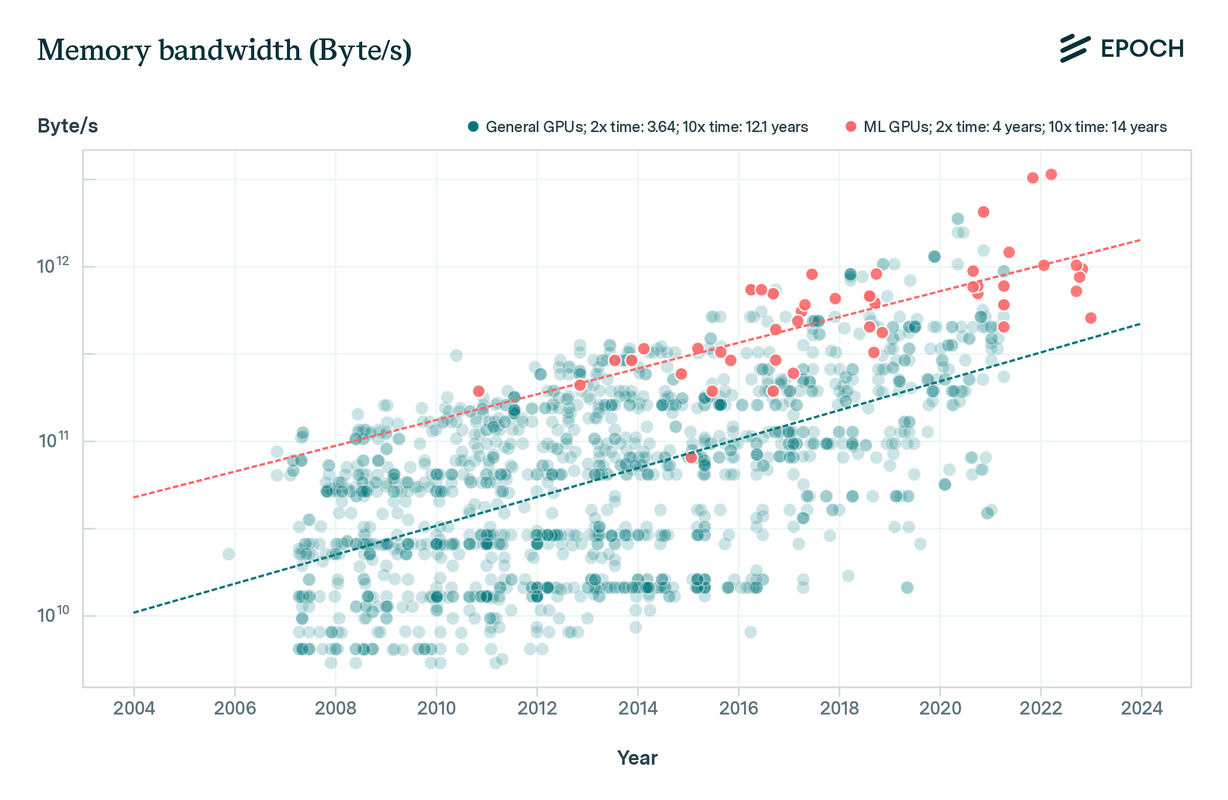

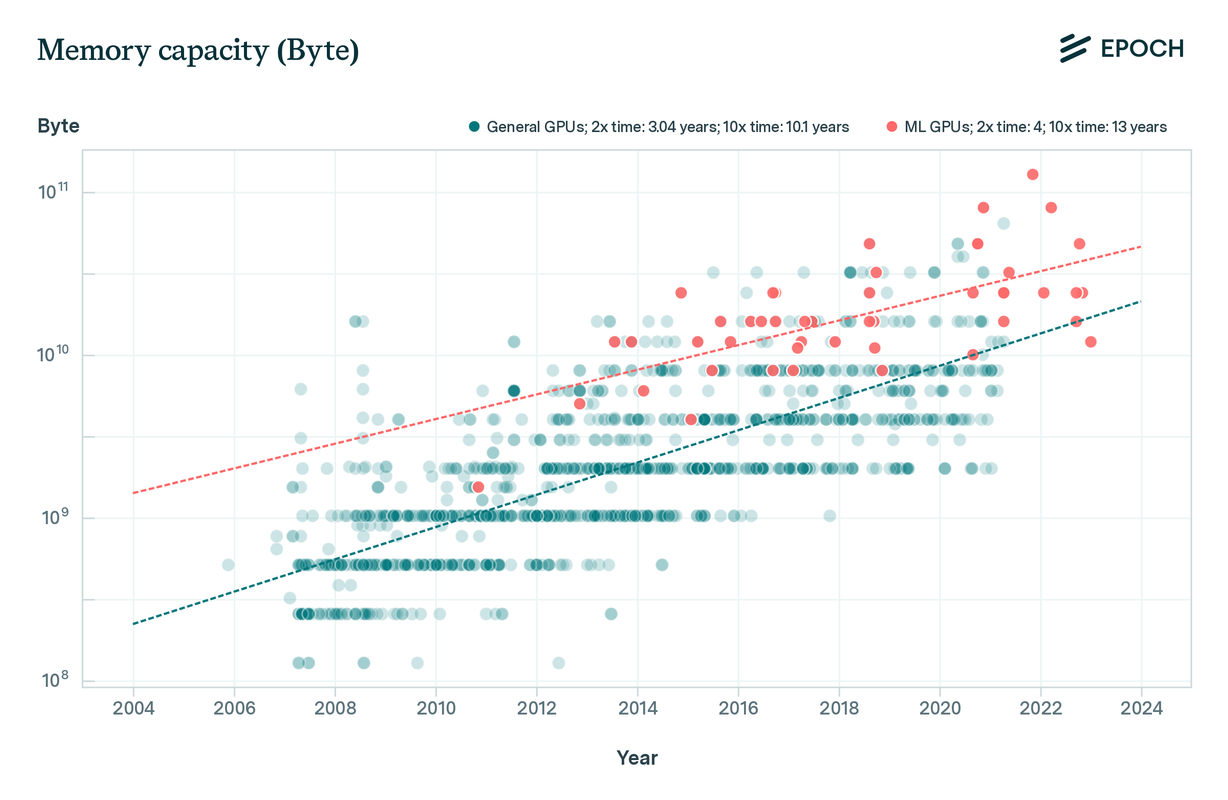

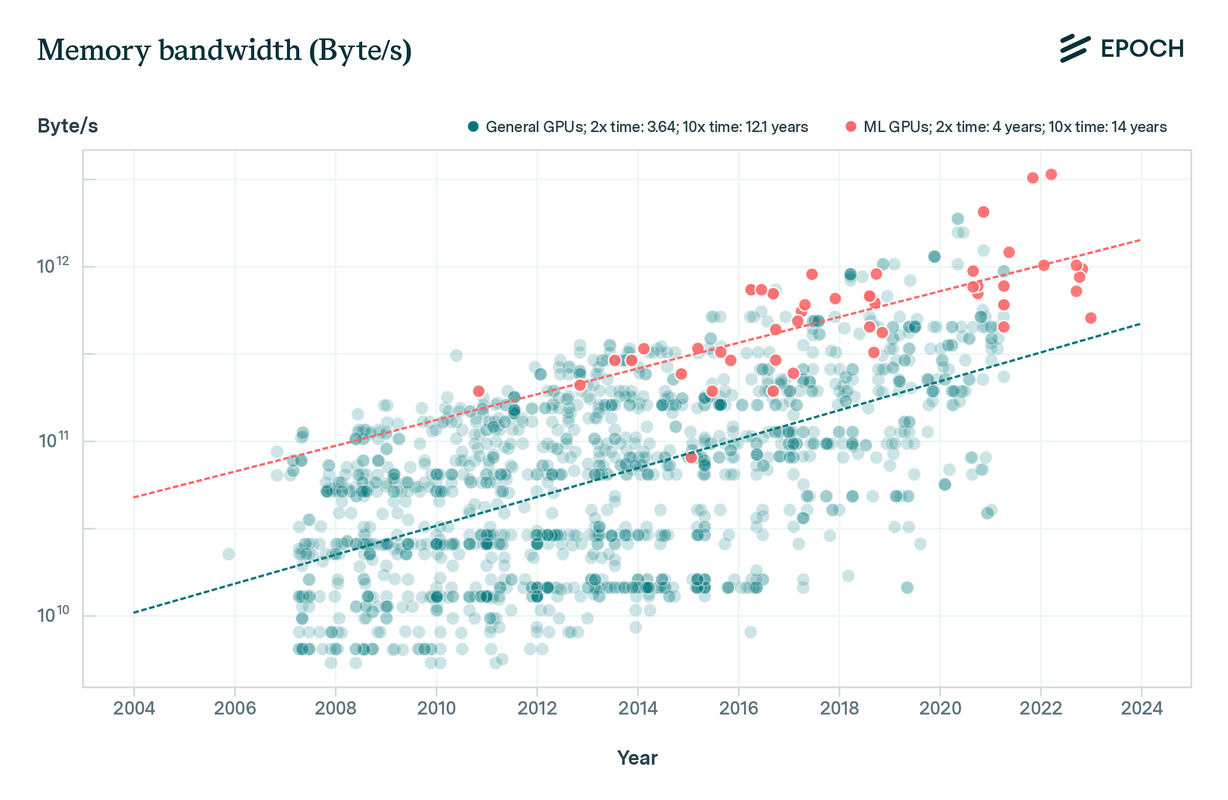

Во-вторых, самое главное отличие потребительских видеокарт от ML-ускорителей - это память. Машинному обучению нужно много памяти (вспоминаем первую экспоненту), и эта память должна быть очень быстрой. И здесь нам стоит внимательно присмотреться к тренду прогресса в характеристиках памяти:

Здесь, как мы видим, дела идут совсем не так радужно. И объем памяти, и ее пропускная способность удваиваются только раз в 4 года. Но ”EpochAI” совсем не затрагивает тему стоимости памяти - а ведь там тоже не всё гладко. Память с высокой пропускной способностью (HBM) стоит дорого. Дорого стоит и ее интеграция с логикой.

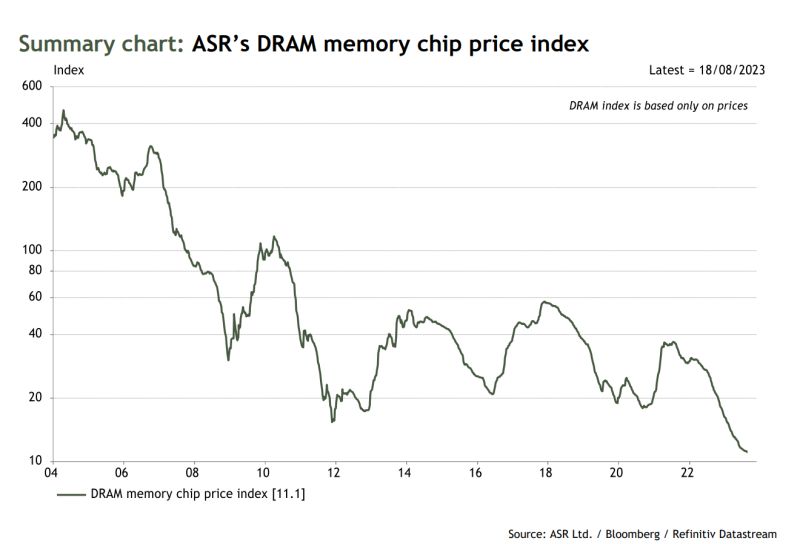

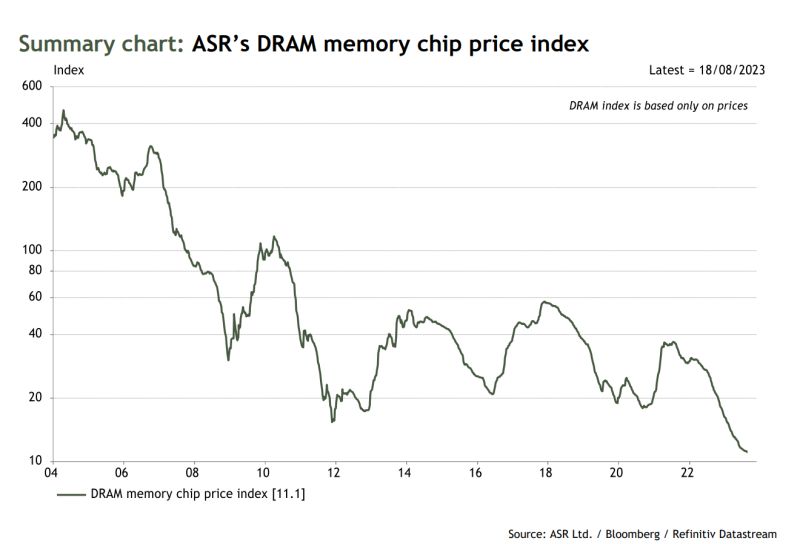

Публичных данных по стоимости HBM нет. По оценкам, она примерно в 5 раз дороже стандартной массовой памяти DRAM. И это уже идёт вразрез с законом Мура: он подразумевает, что самая производительная микроэлектронная технология одновременно будет и самой дешевой. Допустим, на это можно возразить, что по метрике «пропускная способность в расчете на доллар» такая память всё-таки будет выигрывать. И закрыть глаза на то, что производственные процессы для чипов с HBM тоже сильно увеличивают себестоимость. Но скептики могут показать нам еще и такой график:

...где мы видим, что цены на обычную память DRAM c 2012 по 2022 не падали вообще! Проблемы здесь начались примерно тогда же, когда компания TSMC начала «творчески» подходить к названиям своих техпроцессов.

Аналитики в своих прогнозах не слишком надеются на закон Мура. Так, ”Gartner” прогнозирует, что с 2022 по 2027 память HBM подешевеет лишь на 40%.

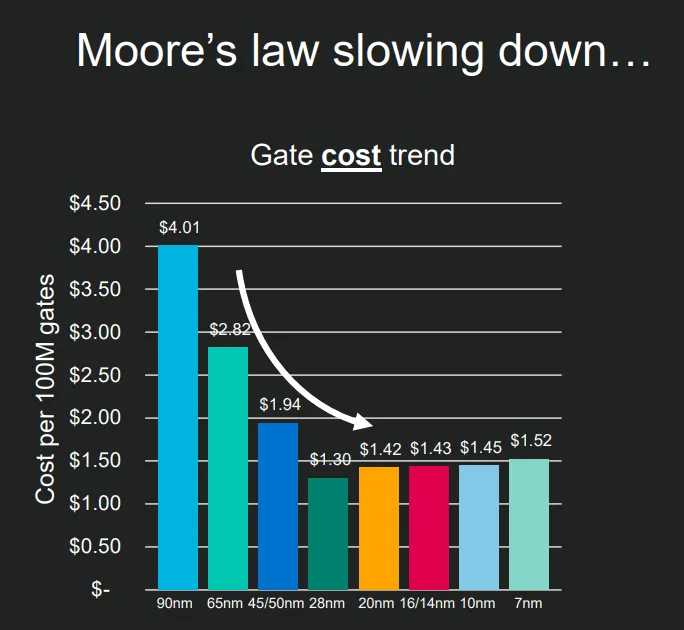

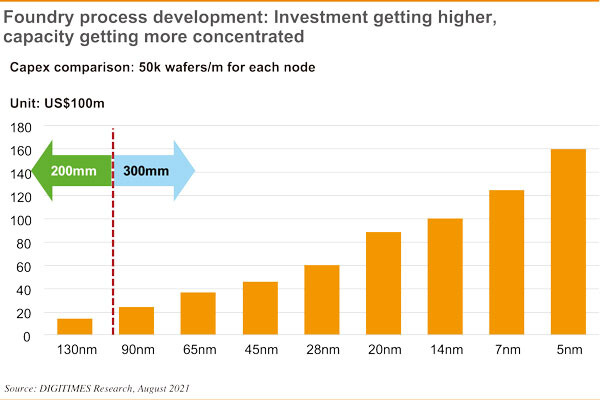

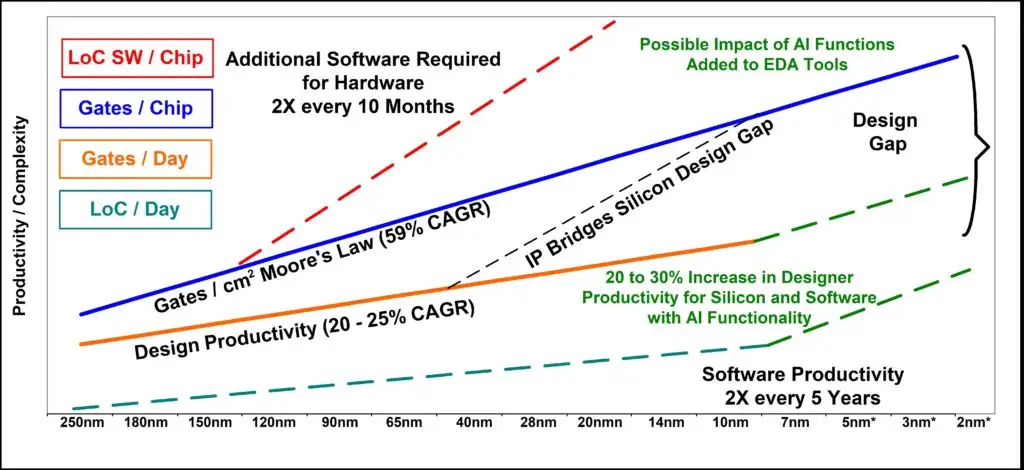

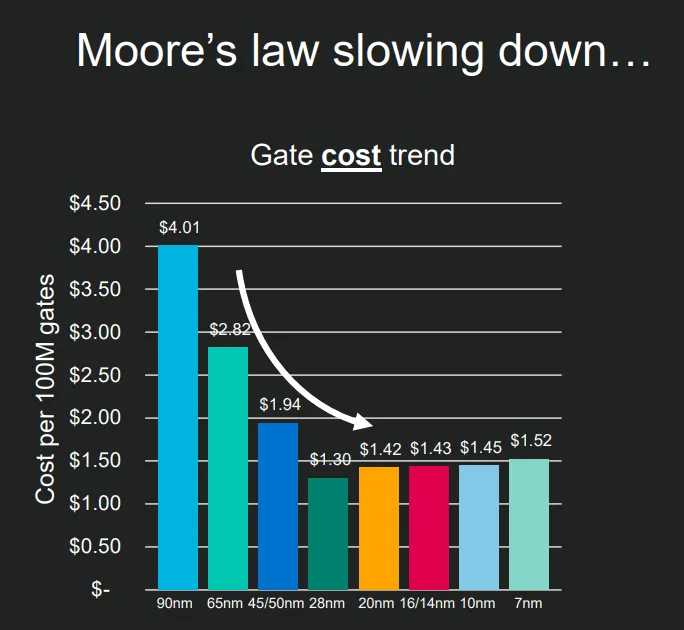

Хорошо, но в чем же дело? Почему муровская экспонента хорошо работала до начала 2010-ых и начала серьезно тормозить после? Ключевым здесь является этот график:

На нем изображена стоимость микроэлектронных логических вентилей, состоящих из транзисторов. Очень хорошо виден переломный момент в точке, соответствующей техпроцессу 28 нм: до этого стоимость вентилей быстро падала, после этого (2012 г.) - начала медленно расти. Курцвейловская экспонента удешевления сломалась. И сломалась гораздо раньше, чем пришла сингулярность.

Постоянно идущая миниатюризация была залогом удешевления микроэлектроники в 1960-2000-ых. Но и физика, и технологические возможности становятся всё более серьезными препятствиями для дальнейшего уменьшения размеров транзисторов. Преодоление этих препятствий даётся недешево.

Ветеран микроэлектронной индустрии Крис Макк писал в 2015, что предыдущие 10 лет стоимость производства 1 мм2 чипа росла в среднем на 10% в год. Пока закон Мура работал, площадь 1 транзистора уменьшалась на 30% в год. Арифметика складывалась в пользу удешевления транзисторов.

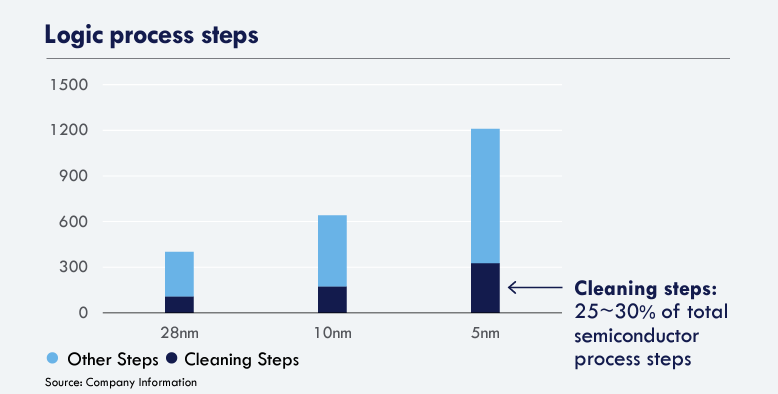

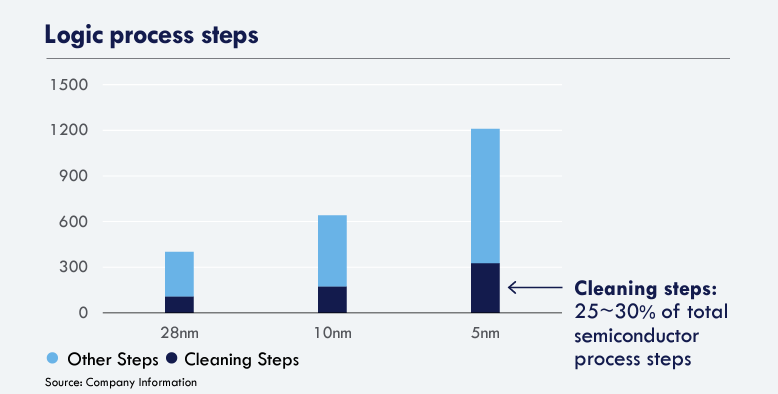

Но когда обозначенные выше препятствия затормозили миниатюризацию, рост издержек производства стал «съедать» весь достигаемый выигрыш. Более того, зная темп миниатюризации, мы можем предположить, что стоимость производства сейчас растёт даже быстрее, чем на 10% в год. И мы знаем, почему: с каждым новым шагом по пути миниатюризации растёт число производственных шагов. Сейчас их число уже перевалило за 1000:

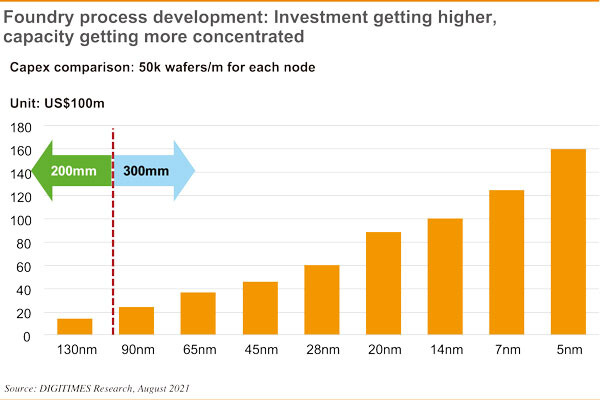

Растут не только операционные затраты, но и капитальные:

...И продолжат расти в будущем:

С уменьшением размера транзисторов до нанометров оборудование для их производства становится баснословно дорогим. Наиболее ярким примером здесь являются литографические машины - ключевое оборудование, обеспечивающее создание нанометровых полупроводниковых структур. На их стоимость приходится порядка 20% капитальных затрат, показанных на двух предыдущих графиках.

В далеком 1981 году одна из популярных проекционных машин Perkin-Elmer Micralign 500 (работавшая еще с микрометрами, а не с нанометрами) стоила 675 тыс. долларов. Через 30 лет “рабочие лошадки“ индустрии, иммерсионные сканеры ASML, стоили уже 40 млн. долларов за штуку. Проходит еще 6 лет, и на сканеры с новой технологией, сверхжестким ультрафиолетом, ценник будет установлен на уровне 140 млн. долларов. Наконец, нынешняя перспективная разработка, сканер с высокой числовой апертурой, стоит уже 330-390 млн. долларов.

График со стоимостью литографических машин, сделанный в 2012. Все вопросы уже сняты, рост действительно идёт по экспоненте

В девятизначные суммы теперь обходится не только производственное оборудование, но и разработка микрочипа. Опасения начала 1980-ых имели под собой почву: микросхемы с миллиардами логических блоков действительно трудно проектировать. Создание чипов сейчас требует больших команд высокооплачиваемых профессионалов, размером в сотни и даже тысячи человек.

С таким валом растущих расходов на миниатюризацию даже удивительно, что индустрии до последнего времени удавалось сохранять темп удешевления вычислений в 2 раза за 2 года. Но, увидев, что фундаментальные факторы больше не поддерживают такой темп, нам остаётся объяснять продолжающийся прогресс факторами второстепенными. Такими, как экономия на повторном использовании старых архитектур («Нвидиа» в своих ускорителях до сих пор пользуется наработками, сделанными в нулевых для рендеринга видеигр), экономия на масштабах производства (серийность), улучшения в программном обеспечении, оптимизация дизайна под ИИ-специфичные операции (трейд-офф между специализацией и универсальностью) и так далее. Многие из них попадают под категорию «низковисящих плодов», которые уже практически полностью собраны.

Возникает вопрос: что дальше? Оптимист Курцвейл был уверен: как только полупроводниковая индустрия упрется в свои нанометровые пределы, знамя подхватит какая-то другая технология. Точно так же, как в своё время планарные транзисторы подхватили знамя у дискретных, дискретные транзисторы - у ламп, и так далее.

Но вот уже как 10 лет планарные транзисторы испытывают трудности, а новых «знаменосцев» не видно даже на горизонте. Да, теоретически есть несколько кандидатов, которые когда-нибудь, в отдаленном будущем, могут заменить собой нынешнюю технологию.

Это квантовые вычисления, которые сейчас находятся в самом зачаточном состоянии и которые максимально далеки от какого-то практического использования. И это фотоника. Более перспективная по сравнению с квантовыми вычислениями в плане зрелости, но всё еще неконкурентоспособная в своём сегодняшнем состоянии.

“Знаменосцам“ надо поторопиться. Пределы интегрированной микроэлектроники уже очень близки. Достаточно прислушаться к Мартину ван ден Бринку, технологическому директору ASML, производителю самого совершенного литографического оборудования. Ван ден Бринк предельно откровенен в своих взглядах на будущий прогресс в этой области. Будет ли создана машина, более совершенная, чем сканер с высокой числовой апертурой? Далеко не факт, отвечает ван ден Бринк. «Долгие годы я подозревал, что [эта] высокая числовая апертура станет последней числовой апертурой, и эти взгляды так и не изменились. […] На данный момент становится очень насущным вопрос: какие компоненты чипов будут слишком мелкими, чтобы их можно было экономически выгодно производить?»

Сборка ЭУФ-сканера на заводе ASML в г. Велдховен

И вот теперь, очертив широкие перспективы (и низкий потолок) улучшения эффективности микроэлектроники, мы можем вернуться к нашей второй экспоненте - росту бюджетов на обучение. А именно, к периоду удвоения этих бюджетов, который в последнее время составлял 7 месяцев. Теперь мы знаем, что этому головокружительному экстенсивному росту сопутствовал более скромный, но всё равно весомый рост производительности электроники на каждый вложенный доллар.

Продолжит ли интенсивная экспонента поддерживать экстенсивную в будущем? На этот счёт множатся сомнения. Если прогресс в микроэлектронике замедлится дальше, замедлится и отдача от вычислительных бюджетов, замедлится и прогресс в ИИ. Причём надо помнить, что вычислительные бюджеты тоже скоро упрутся в потолок. Это создаёт большой риск того, что мы больше не сможем утолять растущие вычислительные аппетиты развития ИИ.

Впрочем, переоценивать значимость этого риска тоже не следует. Как мы уже убедились, до сих пор самыми мощными экспонентами в развитии ИИ были рост вычислительной сложности моделей и рост их обучающих бюджетов - а не закон Мура, на который возлагали все надежды Курцвейл и Моравек. Расцвет ИИ-разработок пришелся на время, когда закон Мура стал сильно отставать от задекларированного графика.

Более того, у нас имеется еще одна интенсивная экспонента, еще одна функция экспоненциального удешевления. С ее помощью у нас получится повышать отдачу даже в условиях «потолка» бюджетов и эффективности микроэлектроники. Разговор о ней пойдет уже в следующей части.

>> Продолжение: 4. Эффективность алгоритмов ИИ >>

_______________________________________________________________

Друзья, я начал вести канал в Телеграм: Экономика знаний. Подписывайтесь!

3. Эффективность микроэлектроники

Идеи технологической сингулярности и непрерывного, поступательного роста способностей ИИ куда-то к невообразимым, сияющим высотам красивы, философски нетривиальны и подразумевают кардинальные изменения во всех аспектах жизни нашего общества. Но на чем теоретики - Вернор Виндж, Ханс Моравек, Рэй Курцвейл - основывали свои грандиозные прогнозы? Какие убедительные доказательства они приводят в пользу своих весьма радикальных взглядов на будущее?

Если убрать все несущественные разногласия, мы приходим лишь к одному необходимому и достаточному условию, своего рода фундаменту, на котором покоится уверенность визионеров в экспоненциальном прогрессе. Это условие было открыто почти 60 лет назад. В 1965 году вышла статья, которая провозгласила новую эпоху в развитии полупроводниковой индустрии. Эпоху, которая продолжается и поныне, хотя автора статьи уже нет на этом свете. Автором был молодой инженер, научный директор компании «Fairchild Semiconductor» Гордон Мур.

И один из важнейших законов этой эпохи был сформулирован Муром следующим образом: чем больше транзисторов мы сможем интегрировать в одном чипе - тем дешевле будет их себестоимость. При этом удваивать число транзисторов в чипе с 1959 (когда был изготовлен первый планарный кремниевый транзистор) по 1965 удавалось каждые 12 месяцев. Если продлить этот тренд в будущее, писал Мур, к 1975 году мы сможем делать микросхемы с 65 тыс. транзисторов - умопомрачительное число с учетом того, что в момент написания статьи самый сложный чип имел всего 50 транзисторов.

Так в нашем рассказе появляется особая разновидность экспоненты: функция экспоненциального убывания. Математически разница в том, что показатель является отрицательным:

Но нас, конечно, больше интересует практическая разница. Её можно описать так. Обычная экспонента подразумевает экстенсивный рост - больше параметров, больше вычислений, больше обучающих данных и так далее. Экспоненциальное убывание описывает интенсивный рост, рост эффективности: мы получаем больше пользы от того же самого количества ресурсов.

Итак, насколько хорошо Гордон Мур спрогнозировал в будущее этот тренд эффективности? Оригинальный прогноз, до 1975 года, неплохо выдержал проверку временем. Под конец этого срока Мур стал чуточку скептичнее: полупроводниковая индустрия уже срывала последние «низковисящие плоды», и после 1980 г. Мур прогнозировал замедление прогресса, с удвоением каждые два года.

На выручку закону Мура пришли его коллеги, Роберт Деннард и Дэвид Хаус. Первый вывел зависимость, что с уменьшением размера транзисторов уменьшается их энергопотребление, что позволяет повысить тактовую частоту вычислителей. Второй обобщил наблюдения Деннарда и Мура, придя к выводу, что производительность компьютеров будет удваиваться каждые 18 месяцев.

В таком виде закон Мура продержался несколько десятилетий. И лёг в основу смелых прогнозов о неизбежности скорого прихода общего искусственного интеллекта. Так, в книге Рэя Курцвейла «The Age of Spiritual Machines» от 1999 года мы увидим вот такой любопытный график:

А любопытен он тем, что, во-первых, Курцвейл расширяет микроэлектронный закон Мура на предыдущие вычислительные технологии, вроде ламп, реле и электромеханических устройств. Во-вторых, футуролог использует метрику «вычисления в секунду на $1000». Это очень хорошая метрика - другие формулировки, вроде плотности размещения транзисторов на микросхеме или номинальной производительности в FLOP/s, не так хорошо увязываются с другими экспонентами ИИ.

В-третьих, вертикальная ось на этом графике имеет логарифмический масштаб. Соответственно, экспоненциальная линия на самом деле является дважды экспоненциальной: темп удешевления вычислений не постоянен и продолжает постепенно ускоряться. «Скорость компьютеров (в расчете на единицу стоимости) удваивалась каждые три года с 1910 по 1950, каждые два года с 1950 по 1966, и сейчас удваивается каждый год», - пишет Курцвейл.

Логика диктует, что скоро производительность компьютеров будет удваиваться каждые полгода, затем каждый месяц, затем каждую неделю… Ну как тут не уверовать в сингулярность? Но нет, у всякой красивой концепции есть свои скептики, и закон Мура - не исключение.

Поскольку закон Мура - одна из самых широко известных экспонент, о нем было построено немало прогнозов и предположений. В основном они вращались вокруг того, что же и когда именно его остановит. Надо сказать, что технологический прогресс с таким темпом - это очень необычный феномен, имеющий мало аналогов в других отраслях промышленности. Закон Мура в этом плане - исключение из общих правил. И эксперты логично предполагали, что скоро это исключение исчерпает свои предпосылки.

Одна из самых ранних попыток «похоронить» закон Мура была в 1984, когда полупроводниковой индустрии следовало переходить на 1-микронный техпроцесс. Число транзисторов в чипе должно было вырасти до 300 тысяч. И эксперты недоумевали: как инженеры смогут проектировать такие сложные устройства? Индустрия только-только начала переходить от проектирования на ватмане за кульманом к специализированному программному обеспечению…

Эксперты оказались не правы: прогресс в микроэлектронике подтолкнул прогресс в цифровых инструментах проектирования, и эта положительная обратная связь продолжает работать и сегодня.

Впрочем, эта ошибка не смутила скептиков, и вскоре последовали новые прогнозы о конце закона Мура. Особенно усилились мрачные предсказания, начиная с нового тысячелетия. Даже сам Курцвейл писал на этот счет: «После 60 лет добросовестной службы, закон Мура умрёт славной смертью не позднее 2019 года. К этому времени элементы транзистора будут всего несколько атомов шириной, и стратегия всё более тонкой фотолитографии исчерпает себя».

На этот раз прогнозы оказались ближе к реальности. Первым пало масштабирование Деннарда, в 2004-05 годах. C уменьшением размера транзистора ниже определенного порога физика сделала невозможным дальнейшее увеличение тактовой частоты. Чуть позже, в 2008, микроэлектронная ассоциация ITRS нарисовала для индустрии более «льготный» долгосрочный план по уменьшению размеров транзисторов, чем следовало из закона Мура. И почти сразу же начала от него отставать.

2019-ый уже прошел. Транзисторов шириной в отдельные атомы мы до сих пор так и не дождались. В 2023 ушел в мир иной сам Гордон Мур. Но жив ли еще закон его имени?

Если раньше эксперты спорили по поводу того, какое именно препятствие в будущем положит конец закону Мура, то сейчас ожесточенные дебаты разгорелись по поводу того, наступил этот конец или еще нет. Мнения разделились. Так, преемник Мура на посту главы «Интел» Пат Гелсинджер уверяет, что прогресс по-прежнему идёт с высоким темпом. Еще один влиятельный представитель полупроводниковой индустрии, глава «Нвидиа» Дженсен Хуанг, начиная с 2017 твердит, что закон Мура мёртв. Но всякий раз прибавляя, что только видеокарты смогут обеспечивать прогресс в эффективности вычислений, и обещая 1000-кратный рост производительности с 2017 по 2025.

Поскольку именно «Нвидиа» производит сейчас львиную долю вычислителей, использующихся для обучения ИИ-моделей, разумно будет оценить состояние закона Мура по характеристикам ее устройств. Посмотрим на эту табличку, где собраны данные по ускорителям «Нвидиа» для датацентров, начиная с 2011 года:

...И мы можем видеть, почему в середине 2010-ых у Дженсена Хуанга появились поводы для недовольства. Лучше все у полупроводниковой индустрии получалось менять таблички с названиями техпроцессов. За 11 представленных лет темп смены этих табличек даже чуть-чуть обогнал обещанное Муром удвоение каждые 24 месяца. Последняя табличка, «4 нм», даже подразумевает пресловутую «ширину в несколько атомов», пускай и в 2022-ом, а не в 2019-ом.

Но под табличками - см. колонку с плотностью транзисторов - нас ждет разочарование. Начиная с 2013, транзисторы упорно отказывались выполнять задекларированные обязательства и уменьшались в размерах далеко не так сильно, как подразумевало название техпроцесса. Особенно характерный пример мы видим с 12-нм техпроцессом: производитель, компания TSMC, табличку сменил, а транзисторы уменьшить «забыл».

Динамика цен тоже не внушает оптимизма. За ускоритель C2070 с чипом площадью 529 мм2 потребитель когда-то выкладывал 4 тыс. долларов. Спустя 11 лет H100 с чипом площадью 814 мм2 обойдется покупателю в 9 раз дороже. Ну ладно, пока дадим ценам шанс и спишем хотя бы часть удорожания на монопольное положение «Нвидиа» и мощный всплеск спроса на ее ускорители.

Благо мы можем оценить курцвейловский показатель «вычисления в секунду на $1000» более точно. Вновь благодаря исследователям из ”EpochAI”. Вот так выглядят агрегированные ими данные:

На этом графике мы видим тренд стоимости операций с плавающей точкой 32-битной точности. Авторы исследования рассчитывают тренд для GPU и получают удешевление в 2 раза каждые 2,1 года. Ура? Закон Мура жив?

Не так быстро: красные точки в правом верхнем углу графика - это свежие потребительские видеокарты, на которых скорее надо гонять «Киберпанк 2077», а не приближать этот самый киберпанк скучным обучением машинных моделей. Фиолетовые точки ML-ускорителей проигрывают им целый порядок. Да и тренд роста там далеко не такой бодрый.

В чем же дело? Во-первых, в том, что для машинных моделей 32-битная точность является избыточной. Последние несколько лет стандартом для индустрии является 16-битная точность. А в нынешнем году начались и попытки перехода на 8-битную. Работа машинных моделей в целочисленном 4-битном формате сейчас тоже является очень «горячей» темой. Производители ускорителей оптимизируют свои ML-устройства в первую очередь под эти форматы.

Ссылаясь на недостаточное количество данных, ”EpochAI” не рассчитывает трендов для этих типов вычислений. Но, на глазок, период 2-кратного удешевления здесь примерно такой же, как и для 32-битных операций с плавающей точкой.

Во-вторых, самое главное отличие потребительских видеокарт от ML-ускорителей - это память. Машинному обучению нужно много памяти (вспоминаем первую экспоненту), и эта память должна быть очень быстрой. И здесь нам стоит внимательно присмотреться к тренду прогресса в характеристиках памяти:

Здесь, как мы видим, дела идут совсем не так радужно. И объем памяти, и ее пропускная способность удваиваются только раз в 4 года. Но ”EpochAI” совсем не затрагивает тему стоимости памяти - а ведь там тоже не всё гладко. Память с высокой пропускной способностью (HBM) стоит дорого. Дорого стоит и ее интеграция с логикой.

Публичных данных по стоимости HBM нет. По оценкам, она примерно в 5 раз дороже стандартной массовой памяти DRAM. И это уже идёт вразрез с законом Мура: он подразумевает, что самая производительная микроэлектронная технология одновременно будет и самой дешевой. Допустим, на это можно возразить, что по метрике «пропускная способность в расчете на доллар» такая память всё-таки будет выигрывать. И закрыть глаза на то, что производственные процессы для чипов с HBM тоже сильно увеличивают себестоимость. Но скептики могут показать нам еще и такой график:

...где мы видим, что цены на обычную память DRAM c 2012 по 2022 не падали вообще! Проблемы здесь начались примерно тогда же, когда компания TSMC начала «творчески» подходить к названиям своих техпроцессов.

Аналитики в своих прогнозах не слишком надеются на закон Мура. Так, ”Gartner” прогнозирует, что с 2022 по 2027 память HBM подешевеет лишь на 40%.

Хорошо, но в чем же дело? Почему муровская экспонента хорошо работала до начала 2010-ых и начала серьезно тормозить после? Ключевым здесь является этот график:

На нем изображена стоимость микроэлектронных логических вентилей, состоящих из транзисторов. Очень хорошо виден переломный момент в точке, соответствующей техпроцессу 28 нм: до этого стоимость вентилей быстро падала, после этого (2012 г.) - начала медленно расти. Курцвейловская экспонента удешевления сломалась. И сломалась гораздо раньше, чем пришла сингулярность.

Постоянно идущая миниатюризация была залогом удешевления микроэлектроники в 1960-2000-ых. Но и физика, и технологические возможности становятся всё более серьезными препятствиями для дальнейшего уменьшения размеров транзисторов. Преодоление этих препятствий даётся недешево.

Ветеран микроэлектронной индустрии Крис Макк писал в 2015, что предыдущие 10 лет стоимость производства 1 мм2 чипа росла в среднем на 10% в год. Пока закон Мура работал, площадь 1 транзистора уменьшалась на 30% в год. Арифметика складывалась в пользу удешевления транзисторов.

Но когда обозначенные выше препятствия затормозили миниатюризацию, рост издержек производства стал «съедать» весь достигаемый выигрыш. Более того, зная темп миниатюризации, мы можем предположить, что стоимость производства сейчас растёт даже быстрее, чем на 10% в год. И мы знаем, почему: с каждым новым шагом по пути миниатюризации растёт число производственных шагов. Сейчас их число уже перевалило за 1000:

Растут не только операционные затраты, но и капитальные:

...И продолжат расти в будущем:

С уменьшением размера транзисторов до нанометров оборудование для их производства становится баснословно дорогим. Наиболее ярким примером здесь являются литографические машины - ключевое оборудование, обеспечивающее создание нанометровых полупроводниковых структур. На их стоимость приходится порядка 20% капитальных затрат, показанных на двух предыдущих графиках.

В далеком 1981 году одна из популярных проекционных машин Perkin-Elmer Micralign 500 (работавшая еще с микрометрами, а не с нанометрами) стоила 675 тыс. долларов. Через 30 лет “рабочие лошадки“ индустрии, иммерсионные сканеры ASML, стоили уже 40 млн. долларов за штуку. Проходит еще 6 лет, и на сканеры с новой технологией, сверхжестким ультрафиолетом, ценник будет установлен на уровне 140 млн. долларов. Наконец, нынешняя перспективная разработка, сканер с высокой числовой апертурой, стоит уже 330-390 млн. долларов.

График со стоимостью литографических машин, сделанный в 2012. Все вопросы уже сняты, рост действительно идёт по экспоненте

В девятизначные суммы теперь обходится не только производственное оборудование, но и разработка микрочипа. Опасения начала 1980-ых имели под собой почву: микросхемы с миллиардами логических блоков действительно трудно проектировать. Создание чипов сейчас требует больших команд высокооплачиваемых профессионалов, размером в сотни и даже тысячи человек.

С таким валом растущих расходов на миниатюризацию даже удивительно, что индустрии до последнего времени удавалось сохранять темп удешевления вычислений в 2 раза за 2 года. Но, увидев, что фундаментальные факторы больше не поддерживают такой темп, нам остаётся объяснять продолжающийся прогресс факторами второстепенными. Такими, как экономия на повторном использовании старых архитектур («Нвидиа» в своих ускорителях до сих пор пользуется наработками, сделанными в нулевых для рендеринга видеигр), экономия на масштабах производства (серийность), улучшения в программном обеспечении, оптимизация дизайна под ИИ-специфичные операции (трейд-офф между специализацией и универсальностью) и так далее. Многие из них попадают под категорию «низковисящих плодов», которые уже практически полностью собраны.

Возникает вопрос: что дальше? Оптимист Курцвейл был уверен: как только полупроводниковая индустрия упрется в свои нанометровые пределы, знамя подхватит какая-то другая технология. Точно так же, как в своё время планарные транзисторы подхватили знамя у дискретных, дискретные транзисторы - у ламп, и так далее.

Но вот уже как 10 лет планарные транзисторы испытывают трудности, а новых «знаменосцев» не видно даже на горизонте. Да, теоретически есть несколько кандидатов, которые когда-нибудь, в отдаленном будущем, могут заменить собой нынешнюю технологию.

Это квантовые вычисления, которые сейчас находятся в самом зачаточном состоянии и которые максимально далеки от какого-то практического использования. И это фотоника. Более перспективная по сравнению с квантовыми вычислениями в плане зрелости, но всё еще неконкурентоспособная в своём сегодняшнем состоянии.

“Знаменосцам“ надо поторопиться. Пределы интегрированной микроэлектроники уже очень близки. Достаточно прислушаться к Мартину ван ден Бринку, технологическому директору ASML, производителю самого совершенного литографического оборудования. Ван ден Бринк предельно откровенен в своих взглядах на будущий прогресс в этой области. Будет ли создана машина, более совершенная, чем сканер с высокой числовой апертурой? Далеко не факт, отвечает ван ден Бринк. «Долгие годы я подозревал, что [эта] высокая числовая апертура станет последней числовой апертурой, и эти взгляды так и не изменились. […] На данный момент становится очень насущным вопрос: какие компоненты чипов будут слишком мелкими, чтобы их можно было экономически выгодно производить?»

Сборка ЭУФ-сканера на заводе ASML в г. Велдховен

И вот теперь, очертив широкие перспективы (и низкий потолок) улучшения эффективности микроэлектроники, мы можем вернуться к нашей второй экспоненте - росту бюджетов на обучение. А именно, к периоду удвоения этих бюджетов, который в последнее время составлял 7 месяцев. Теперь мы знаем, что этому головокружительному экстенсивному росту сопутствовал более скромный, но всё равно весомый рост производительности электроники на каждый вложенный доллар.

Продолжит ли интенсивная экспонента поддерживать экстенсивную в будущем? На этот счёт множатся сомнения. Если прогресс в микроэлектронике замедлится дальше, замедлится и отдача от вычислительных бюджетов, замедлится и прогресс в ИИ. Причём надо помнить, что вычислительные бюджеты тоже скоро упрутся в потолок. Это создаёт большой риск того, что мы больше не сможем утолять растущие вычислительные аппетиты развития ИИ.

Впрочем, переоценивать значимость этого риска тоже не следует. Как мы уже убедились, до сих пор самыми мощными экспонентами в развитии ИИ были рост вычислительной сложности моделей и рост их обучающих бюджетов - а не закон Мура, на который возлагали все надежды Курцвейл и Моравек. Расцвет ИИ-разработок пришелся на время, когда закон Мура стал сильно отставать от задекларированного графика.

Более того, у нас имеется еще одна интенсивная экспонента, еще одна функция экспоненциального удешевления. С ее помощью у нас получится повышать отдачу даже в условиях «потолка» бюджетов и эффективности микроэлектроники. Разговор о ней пойдет уже в следующей части.

>> Продолжение: 4. Эффективность алгоритмов ИИ >>

_______________________________________________________________

Друзья, я начал вести канал в Телеграм: Экономика знаний. Подписывайтесь!